Posljednjih mjeseci došlo je do značajnog pomaka u razvoju chatbotova. Počevši od Character.ai prošlog proljeća, preko ChatGPT-a u studenom, pa sve do Barda u prosincu, iskustva korisnika koje pružaju jezični modeli specijalizirani za razgovor bile su vruće teme mnogih medija i grupa.

No, pojavom otvorenog pristupa i alternativa otvorenog koda dodatno je potaknuto zanimanje.

Trenutačno stanje chatbotova otvorenog koda

Uspjeh ovih modela za razgovor temelji se na dvije paradigme obuke: precizno usmjeravanje i potkrepljivanje učenja putem povratnih informacija od ljudi (RLHF – Reinforcement Learning with Human Feedback).

Iako su uloženi značajni napori u izgradnju otvorenih okvira za pomoć u obuci ovakvih modela, poput trlX, trl, DeepSpeed Chat i ColossalAI, nedostaje otvorenih modela koji imaju primijenjene obje paradigme.

U većini modela, precizno usmjeravanje se primjenjuje bez RLHF obuke zbog složenosti koju ona uključuje.

Nedavno su Open Assistant, Anthropic i Stanford počeli graditi RLHF skupove podataka dostupnima javnosti.

Ti skupovi podataka, zajedno s jednostavnom obukom RLHF koju pruža trlX, čine osnovu prvog velikog modela obuke i RLHF-a koji danas predstavljamo – StableVicuna.

StableVicuna je prvi veliki chatbot otvorenog koda obučen putem potkrepljenog učenja iz ljudskih povratnih informacija (RLHF). StableVicuna je dodatno precizno usmjerena i RLHF obučena verzija Vicuna v0 13b, koja je instrukcijski usmjerena verzija LLaMA 13b modela.

Za sve zainteresirane više od Vicuni možete pronaći ovdje.

Evo nekoliko primjena ovog chatbota:

- Pitajte ga da obavi osnovnu matematiku

- Pitajte ga da napiše kod

- Pitajte ga da vam pomogne s gramatikom

U priloženoj tabeli su navedeni neki pokazatelji koji prikazuju ukupnu učinkovitost StableVicune u usporedbi s drugim otvorenim chatbotima slične veličine.

Da bi postigli snažne performanse StableVicune, autori koriste Vicunu kao osnovni model i slijede tipični trostupanjski RLHF cjevovod opisan od strane Steinnona i Ouyanga. Konkretno, dodatno se obučava osnovni Vicuna model s nadzorom usmjeravanja (SFT) koristeći mješavinu tri skupa podataka:

OpenAssistant Conversations Dataset (OASST1), korpus razgovora u stilu pomoćnika generiran od strane ljudi, s anotacijama ljudi, koji se sastoji od 161.443 poruke raspodijeljene preko 66.497 stabala razgovora, na 35 različitih jezika;

GPT4All Prompt Generations, skup podataka od 437.605 upita i odgovora generiranih pomoću GPT-3.5 Turbo;

Alpaca, skup podataka od 52.000 uputa i demonstracija generiranih pomoću OpenAI-jevog text-davinci-003 engina.

Koristi se trlx za obuku modela nagrade koji se prvo inicijalizira iz daljnjeg SFT modela na sljedećim RLHF skupovima podataka o preferencijama:

OpenAssistant Conversations Dataset (OASST1) sadrži 7213 uzoraka preferencija;

Anthropic HH-RLHF, skup podataka preferencija o korisnosti i neškodljivosti AI asistenta koji sadrži 160.800 ljudskih oznaka;

Stanford Human Preferences (SHP), skup podataka od 348.718 kolektivnih ljudskih preferencija u odnosu na odgovore na pitanja/upute u 18 različitih područja, od kuhanja do filozofije.

Napokon, koristi se trlX za izvođenje Proximal Policy Optimization (PPO) potkrepljivanje učenja kako bismo izveli RLHF obuku SFT modela kako bi došli do StableVicune!

Kako do StableVicuna-13B?

StableVicuna se nalazi na HuggingFace Hubu! Model se može preuzeti kao weight delta u odnosu na izvorni LLaMA model.

Izraz weight delta odnosi se na razlike ili promjene između novog modela (StableVicuna) i izvornog modela (LLaMA). Kada se preuzima weight delta, zapravo se preuzima prilagodbe potrebne za pretvaranje izvornog LLaMA modela u poboljšanu verziju StableVicuna.

To omogućuje apliciranje tih promjena na izvorni model bez potrebe za preuzimanjem cijelog novog modela, što je učinkovitije i zahtijeva manje prostora za pohranu podataka.

Da biste dobili StableVicuna-13B, možete preuzeti weight delta ovdje.

Međutim, imajte na umu da morate imati pristup izvornom LLaMA modelu, što zahtijeva zasebno prijavljivanje za LLaMA weight putem poveznice navedene u repozitoriju na GitHubu ili ovdje. Kada imate i weight delta i LLaMA weight, možete koristiti skriptu koja se nalazi u GitHub repozitoriju kako biste ih kombinirali i dobili StableVicuna-13B.

Najava nadolazećeg sučelja za chatbot

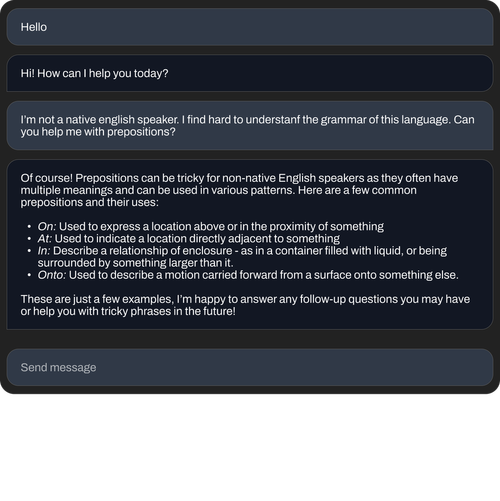

Uz chatbot, najavljeno je i sučelje za razgovor koje je u završnoj fazi razvoja. Sljedeći snimci zaslona daju uvid u ono što korisnici mogu očekivati.

Predanost kontinuiranom poboljšanju

Ovo je tek početak za StableVicuna. Tijekom sljedećih tjedana radit će se na unaprjeđenju ovog chatbota i implementaciji Discord bota na Stable Foundation poslužitelj.

Autori stoga potičeu da isprobate StableVicuna i pružite im dragocjene povratne informacije kako bi poboljšali korisničko iskustvo.

Za sada možete isprobati model na HuggingFace putem ove poveznice.